AI撞上“数据墙”是必然,安全可信才是最大瓶颈!对话清华大学崔鹏副教授:未来3~5年是安全可信AI的黄金期,AI+工业是中国的“先手棋”

长期以来,人工智能(AI)领域奉行“数据规模越大越好”的信念,但近期业界却传出大模型进化遭遇“数据墙”的消息。

据报道,OpenAI、谷歌和Anthropic在开发新一代模型时遭遇瓶颈,无法实现此前那样的突破性进展。图灵奖得主杨立昆(Yann LeCun)和OpenAI前首席科学家伊利亚•苏茨克维(Ilya Sutskever)等业界大佬直言,规模法则(Scaling Law)已触及天花板。

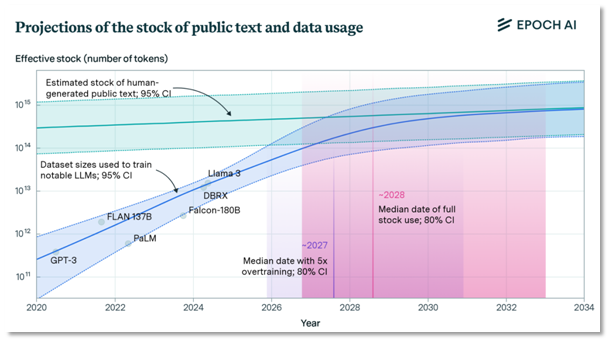

美国技术研究公司Epoch AI预测,互联网上可用的高质量文本数据可能会在2028年耗尽。

对公开文本数据使用量的预测 图片来源:Epoch AI

“数据墙”是否真实存在,未来的AI将走向何处?如果真有“数据墙”,大模型研发企业又该如何找寻新的出路?就此,《每日经济新闻》记者近日专访了清华大学计算机科学与技术系长聘副教授崔鹏。

崔鹏表示,目前大模型还是以大规模数据驱动为范式的,而数据总有用完的一天,肯定会碰上“数据墙”。在他看来,数据问题只是目前AI面临的一小部分难题。更大的问题在于,目前的AI缺少泛化能力,使其缺乏安全可信性。

他认为,未来3~5年将是打造安全、可信AI的黄金期,因为单纯依靠规模法则或者蛮力法(Brute Force,指用大量计算资源和穷举所有可能的方式来解决问题),边际收益已经逐渐降低,必须寻找新的突破点。

而在谈及AI助推行业升级的话题时,他表示,我国资源禀赋最为突出的领域其实是工业。AI与工业场景相结合,反而是我们很重要的一步“先手棋”。

崔鹏于2010年获得清华大学博士学位,长期聚焦因果推断与AI的融合研究,在国际上自主提出并发展了因果启发的稳定学习理论方法体系,在智慧医疗、工业制造及互联网经济等领域实现重要应用。崔鹏已在AI及数据挖掘领域顶级国际期刊和会议上发表论文百余篇,并先后获得7项国际会议及期刊最佳论文奖,还(曾)担任IEEE TKDE、IEEE TBD、ACM TIST、ACM TOMM等国际顶级期刊的编委。

崔鹏图片来源:受访者供图

“数据墙”确实存在,但AI最大的瓶颈是安全可信

NBD:您认为目前AI发展是否达到了一个瓶颈?是否存在所谓的“墙”呢?

崔鹏:这一代AI的技术路径,总体上仍遵循大规模数据驱动的范式,依赖于算法、算力和数据这三要素。而目前,基本所有互联网中的高质量数据,都已经投喂给了大模型。除此之外,大模型还吸收了大量的人工标注数据。如果一直维持规模法则这样的范式,到一定阶段,AI肯定是会撞上“数据墙”的。

但如果从底层的学习机理和学习机制来看,当前AI的泛化能力实际上是缺失的。也就是说,AI只能处理在训练阶段已经见过的类似案例,对于未见过类似的案例则难以应对。

泛化能力的缺失导致了一个严重的问题:当我们将AI应用于开放场景时,模型往往会在未被充分训练过的场景下“胡说八道”。这构成了AI面临的最大技术瓶颈——在安全可信方面的能力缺失,也就是说,目前的AI既够不安全也不够可信。

NBD:那我们应该如何解决AI的安全可信问题呢?

崔鹏:目前来看,有三个层面:探索新的学习机理,建立新的数据科学体系,还要能够提出新的评估手段。做到三位一体,才能够真正解决AI的安全和可信问题。

首先,传统的机器学习基于“独立同分布”的假设,认为训练数据和测试数据是相似的。这种假设给予机器学习明确的优化目标,但在实际应用中,这种假设可能会带来一些问题,比如过拟合(模型过于依赖训练数据,无法应对新情况)或拟合无关的信息。特别是在大规模数据中,变量之间可能存在虚假的关联,从而影响到模型的准确性。相比之下,因果统计会更加关注变量之间的因果关系(即明确哪些因素真正影响结果),能够更好地应对数据分布变化带来的问题。

其次,我们需要转变对数据的处理方式,发展新的数据科学体系,从被动积累数据转变为主动获取有效数据,并使数据与智能形成互动的反馈循环——数据产生智能,智能又能够定向告诉我们应该去产生或者收集什么样的数据。

第三是建立新的评估体系,以准确刻画模型的能力边界和风险。通过评估来明确模型风险可能存在的具体情境,在明确这些风险后,我们就应当避免在那些高风险情境下使用AI模型来完成任务。

当AI遇上高风险行业,得分就算高达99.99也是不够的

NBD:市面上不乏许多表现出色的模型,但为何在高风险行业,仍然鲜见AI的广泛应用呢?

崔鹏:现在关于AI有两个论调,一种观点认为,AI的发展已经达到一个前所未有的高度,诸如AGI(通用人工智能)和ASI(超级智能)等概念开始被广泛讨论。然而,另一种观点认为,现在的AI,其实并没有在严肃行业里真正解决实际问题。

AI在实际应用中的落地面临诸多困难,因为AI的泛化能力无法得到保证,那么其在开放场景下的安全性和可信性就无法得到保证。为什么我们敢用人去解决这些风险比较高的任务呢?就是因为相较于现在的AI,人的可信性肯定要高很多。

对于AI,市面上有各种各样的评测和榜单,但其实这些都是对模型整体能力的刻画,但它并不足以精确描绘出模型在具体应用场景下的能力边界。

那么,即便模型拿到99分、甚至是99.99分的高分,也可能不足以说明它在实际应用中是安全可信的。因为我们无法确切知晓,其风险究竟会处于何种情况之下。因此,对于AI而言,确实需要建立一套新的评估体系,准确评估和界定模型的能力边界,这一点至关重要。

图片来源:视觉中国-VCG41N1472123004

未来3~5年是打造安全可信AI的黄金期

NBD:在2024年世界互联网大会乌镇峰会网络安全技术发展与国际合作论坛上,有业内人士将AI安全危机总结为“三化”,即:黑箱化(指AI系统内部的决策过程对用户和开发者来说是不透明的)、黑产化(导致深度伪造泛滥成灾)和武器化(导致黑客攻击愈演愈烈)。您认为在解决“AI黑箱”的问题上,有哪些比较有效的技术手段呢?

崔鹏:从技术层面来看,AI实际上正逐步趋向于“黑箱化”发展。但是从性能角度来讲,AI的能力也在不断增强。因此,在一定程度上,可以说我们让渡了对模型的控制权,换取了其性能上的提升。

但一个新技术的出现,到底是不是需要它完全透明、可解释,其实也是一个问题。因为本质上来讲,一项技术是否能够为广大消费者所接受,并不取决于它是不是可解释、是不是透明的,而取决于它是不是安全可信的。

比如,人们敢开车,不是因为每个人都懂发动机的发动原理;人们敢坐飞机,也不是因为每个人都懂空气动力学。

所谓“可解释性”,实际上是指能够被人类所理解。而人类的解释逻辑往往基于因果。因此,如果机器的推理逻辑与人类的推理逻辑能够对齐,那整个工作机制对于人类而言,就是可解释的。

NBD:您认为我们什么时候能够构建好安全可信的AI呢?

崔鹏:我认为,未来3~5年将是打造安全可信AI的黄金期。现在AI又到了一个十字路口,按照(已知)技术路径来走,大家会越来越清楚AI的最终发展形态。因此,会有更多的人关注AI的安全可信,因为单纯依靠规模法则或蛮力法,边际收益已经逐渐降低,必须寻找新的突破点。

实际上,目前已有一些相对成熟的技术手段,能够在一定程度上解决这些问题。底层的基础理论体系已经构建出来了,关键技术也有了,接下来要解决的就是如何将这些技术与实际应用场景进行打磨和对齐。因此我认为,解决这个问题所需的时间并不会太长。

但是,在安全可信的机制这一层面,相对于欧美国家,我们的投入和关注量都是相对少的。

如果我们观察美国的科研规划或顶尖学者们的研究方向,会发现他们实际上是“两条腿在走”。一方面,是靠大规模算力、大规模数据来打造更强大的模型。但与此同时,他们也在积极探索另一条路,即如何保障AI的安全性和可信性。

“安全可信”会是2025年AI发展的一个重要趋势。在当前阶段,乃至我国大的战略中,“安全可信”都占据着举足轻重的地位。如果这一步棋走好了,或许不能说是“弯道超车”,但可以说是“换道超车”。

AI与工业结合,是中国的“先手棋”

NBD:AI与自动化的结合正改变一些传统行业。您认为AI会如何推动这些行业的智能升级呢?具体的应用场景又会有哪些呢?

崔鹏:这一波大模型出来以后,它的主要应用场景是互联网。但从我国的资源禀赋讲,互联网可能并不一定是最有比较优势的“战场”。我国资源禀赋最为突出的领域其实是工业。无论是制造业的数据量、质量和规模,还是我们的支持力度,都远超其他国家。AI与工业场景相结合,反而是我们很重要的一步“先手棋”。

我们现在讲“新质生产力”,那新质生产力的核心是什么?其实,第四次工业革命的核心在于利用AI解决这些严肃行业的生产力问题,用智能去赋予工业更高的生产效率。事实上,第四次工业革命,其核心仍然是工业革命。

在第三次工业革命——我们称之为数字化革命(其中也包括自动化)——的推动下,催生了非常复杂的工业生产链条。而在此背景下,智能化将是一个必然趋势。因为人最不擅长的就是处理大规模、高维度的数据,在面对复杂任务时,是远远跟不上需求的。而大模型一天就能处理几十万本书的信息,与人的能力完全不在一个量级。从这个角度来看,AI是大有可为的。

例如,对于极为复杂的产品线,一旦因故障而停机,我们可能需要花费几小时甚至几天的时间来进行故障排查,但成本实在太高了。我们现在正在做的一项工作是通过分析设备的故障代码,利用AI技术精准定位故障点,大幅度节约人力成本,提高生产效率。那这对于工业生产而言,无疑解决了非常大的问题。